深度学习怎么调用参数

- 深度学习

- 2024-09-24 22:53:02

- 8636

I、深度学习炼丹-超参数调整

II、【吴恩达深度学习】—参数、超参数、正则化吴恩达深度学习课程

课程学习总结

吴恩达深度学习课程由吴恩达与网易联合授课,免费向公众开放。 网易吴恩达和黄海博士提供课程笔记。 课程资源包括网易云课堂课程和支讲义。

参数与超参数

1.1超参数的定义:选择算法的参数时,如学习率、迭代次数、隐层数、隐层数等单位和活函数。 数字影响最终参数W和b的值。

1.2超参数搜索:先设定一个大概的学习率,通过实际学习观察效果,通过经验调整到更好的值等。

神经网络中的正则化

正则化,包括L2正则化和dropout正则化,旨在减少过度拟合。

2.1L2正则化:机器学习中引入的正则化方法,应用于线性回归和逻辑回归。

2.2Dropout正则化:随机禁用神经网络中的神经元,以简化网络、加快训练速度、防止过拟合。 实现方法包括反向dropout。

2.3数据放大:通过水平翻转、裁剪等方式增加训练数据,减少过拟合。 可应用于学字符识别等场景。

2.4提前停止:为了防止模型在训练过程中过拟合,选择损失函数最小的迭代点停止。

好处:节模型训练时间并防止过度拟合。

缺点:损失J尚未达到最小值,可能会错过全最优解。

深度学习中的超参数调优:关键策略和实践

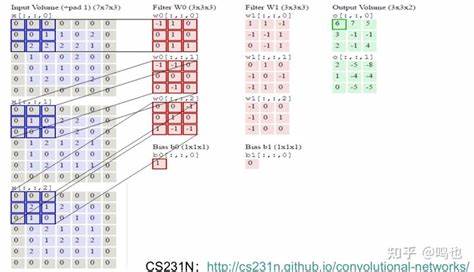

在深度学习中,超参数不是学习,而是手动设置,例如最佳学习率、训练次数。 轮次、批量大小和图像大小等。 超参数调整是优化模型性能的关键步骤。 通常,80%的训练数据用于训练,20%用于验证集中的验证,以减少总体误差。 设计网络架构时,卷积核大小、cbr组合、权重初始化方法等固定参数也很重要。

图像大小和数据增强对模型性能有显着影响。 批量大小的选择需要在计算机速度和内存消耗之间取得平衡。 模型的学习速度与batchsize密切相关,两者共同影响模型的性能和收敛速度。

促进者的选择对于模型训练至关重要,例如SGD、Adam等,各有优缺点,应根据项目特点和数据进行选择。 特征。 PyTorch中的Adadelta、SGD和RMSprop等优化器提供了丰富的配置选项。 FinTech模型(迁移学习)利用预训练模型的加权初始化,根据应用需求调整不同层的学习率。 在实践过程中,只有不断测试和理解这些策略,才能显着提高模型性能。

II、【吴恩达深度学习】—参数、超参数、正则化吴恩达深度学习课程

课程学习总结

吴恩达深度学习课程由吴恩达与网易联合授课,免费向公众开放。 网易吴恩达和黄海博士提供课程笔记。 课程资源包括网易云课堂课程和支讲义。

参数与超参数

1.1超参数的定义:选择算法的参数时,如学习率、迭代次数、隐层数、隐层数等单位和活函数。 数字影响最终参数W和b的值。

1.2超参数搜索:先设定一个大概的学习率,通过实际学习观察效果,通过经验调整到更好的值等。

神经网络中的正则化

正则化,包括L2正则化和dropout正则化,旨在减少过度拟合。

2.1L2正则化:机器学习中引入的正则化方法,应用于线性回归和逻辑回归。

2.2Dropout正则化:随机禁用神经网络中的神经元,以简化网络、加快训练速度、防止过拟合。 实现方法包括反向dropout。

2.3数据放大:通过水平翻转、裁剪等方式增加训练数据,减少过拟合。 可应用于学字符识别等场景。

2.4提前停止:为了防止模型在训练过程中过拟合,选择损失函数最小的迭代点停止。

好处:节模型训练时间并防止过度拟合。

缺点:损失J尚未达到最小值,可能会错过全最优解。

上一篇:比较有含金量的数据分析

下一篇:图像识别的应用场景有哪些