为什么深度学习的参数很难调

- 深度学习

- 2024-09-28 11:00:32

- 5730

本文目录一览

2.参数初始化:高斯若某两层的梯度计算相差太大,就要调整小的那层的std了

3.活函数relu+bn

4.数据预处理方式:zero-center

5.梯度裁剪:限最大梯度或者设置阀值,让梯度强等于10,20等

6.对于小的数据集,dropout=0.5和L2正则化项,效果不错

7.优化方法:SGD+Momentum效果往往可以胜过adam等,虽然adam收敛更快,据说初始几轮momentum设置的小一点会更好,这点待验证。

8.rnntrickbatchsize=1效果会更好(待验证)

9.earlystop或者有个初始模型接着训练

10.参数初始化:可以先用随机初始化的方式训练一个简单的网络模型,再将训练好的权值初始化给复杂的网络模型,复杂的网络模型采用高斯初始化可能会更好(VGG)

首先,调试处理要求我们确保数据集完整,并将其分为训练集、验证集和测试集。 监控模型在训练集和验证集上的性能指标,如损失函数值、准确率等。 利用可化工具,如损失曲线、学习率曲线等,分析模型的训练过程。 此外,我们需要检查模型是否出现过拟合或欠拟合现象,可以通过增加数据量、添加正则化项、减少模型复杂度等方法进行处理。

其次,超参数调优是提高模型性能的关键步骤。 了解每个超参数的作用和影响,如学习率、批大小、网络层数等。 设置一个合理的初始范围,覆盖可能的最佳值,可以参考文献、先前经验或者使用默认值作为初始范围。 使用启发式方法,如网格搜索、随机搜索、贝叶斯优化等,寻找最佳超参数配置,以提高模型性能和减少训练时间。 同时,迭代地调整超参数,根据实验结果的反馈逐步缩小范围,避免引入过多复杂性。

归一化网络活函数可以提高模型的稳定性和训练效果。 常用的归一化活函数有BatchNormalization(BN)、LayerNormalization(LN)、GroupNormalization(GN)和InstanceNormalization(IN)。 这些方法通过在训练过程中对活值进行标准化处理,加快模型收敛速度、减少梯度消失问题,并有助于模型泛化。

将BatchNormalization(BN)应用于神经网络时,需要在每个隐层的输出之后添加BatchNormalization层。 设置合适的超参数,如momentum、epsilon和axis,以确保模型性能和收敛速度。 训练模型时,每个训练迭代中对批次数据进行标准化处理。 验证和测试模型性能时,计算损失和指标以评估模型效果。

Softmax回归是一种常用的多类别分类模型,适用于多类别分类问题。 它使用softmax函数将输入转换为概率分布,表示每个类别的概率。 进行多类别分类时,准备包含特征和标签的训练数据集,并对特征进行预处理,初始化模型参数,定义模型结构,定义损失函数,并通过优化算法最小化损失函数。 最后,使用测试数据集评估模型性能,进行预测时计算概率分布,选择概率最高的类别作为预测结果。

深度学习作为工智能的核心技术,受到越来越多的关注。 但是另一方面深度学习技术仍不完美,有待于进一步提升。 很多刚接触深度学习的同学可能比较好奇,目前深度学习技术存在哪些限性呢?主要有以下几方面

一是深度神经网络的模型复杂度高,巨量的参数导致模型尺寸大,难以部署到移动终端设备。

二是模型训练所需的数据量大,而训练数据样本获取、标注成本高,有些场景样本难以获取。

三是应用门槛高,算法建模及调参过程复杂繁琐、算法设计周期、系统实施维护困难。

四是存在可解释性问题,由于内部的参数共享和复杂的特征抽取与组合,很难解释模型到底学习到了什么,但出于安全性考虑以及伦理和法律的需要,算法的可解释性又是十分必要的。

⓵深度学习调参有哪些技巧

1.学习率fixedlr从0.01到10的-6或-7就可以了2.参数初始化:高斯若某两层的梯度计算相差太大,就要调整小的那层的std了

3.活函数relu+bn

4.数据预处理方式:zero-center

5.梯度裁剪:限最大梯度或者设置阀值,让梯度强等于10,20等

6.对于小的数据集,dropout=0.5和L2正则化项,效果不错

7.优化方法:SGD+Momentum效果往往可以胜过adam等,虽然adam收敛更快,据说初始几轮momentum设置的小一点会更好,这点待验证。

8.rnntrickbatchsize=1效果会更好(待验证)

9.earlystop或者有个初始模型接着训练

10.参数初始化:可以先用随机初始化的方式训练一个简单的网络模型,再将训练好的权值初始化给复杂的网络模型,复杂的网络模型采用高斯初始化可能会更好(VGG)

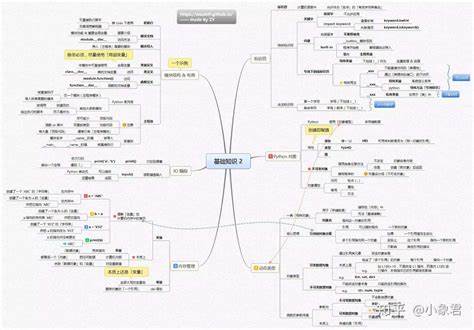

⓶深度学习自学笔记十:超参数调试、正则化

在深度学习中,调试处理和超参数的合适范围是非常关键的。 为了达到理想的模型性能,我们需要注意以下几点:首先,调试处理要求我们确保数据集完整,并将其分为训练集、验证集和测试集。 监控模型在训练集和验证集上的性能指标,如损失函数值、准确率等。 利用可化工具,如损失曲线、学习率曲线等,分析模型的训练过程。 此外,我们需要检查模型是否出现过拟合或欠拟合现象,可以通过增加数据量、添加正则化项、减少模型复杂度等方法进行处理。

其次,超参数调优是提高模型性能的关键步骤。 了解每个超参数的作用和影响,如学习率、批大小、网络层数等。 设置一个合理的初始范围,覆盖可能的最佳值,可以参考文献、先前经验或者使用默认值作为初始范围。 使用启发式方法,如网格搜索、随机搜索、贝叶斯优化等,寻找最佳超参数配置,以提高模型性能和减少训练时间。 同时,迭代地调整超参数,根据实验结果的反馈逐步缩小范围,避免引入过多复杂性。

归一化网络活函数可以提高模型的稳定性和训练效果。 常用的归一化活函数有BatchNormalization(BN)、LayerNormalization(LN)、GroupNormalization(GN)和InstanceNormalization(IN)。 这些方法通过在训练过程中对活值进行标准化处理,加快模型收敛速度、减少梯度消失问题,并有助于模型泛化。

将BatchNormalization(BN)应用于神经网络时,需要在每个隐层的输出之后添加BatchNormalization层。 设置合适的超参数,如momentum、epsilon和axis,以确保模型性能和收敛速度。 训练模型时,每个训练迭代中对批次数据进行标准化处理。 验证和测试模型性能时,计算损失和指标以评估模型效果。

Softmax回归是一种常用的多类别分类模型,适用于多类别分类问题。 它使用softmax函数将输入转换为概率分布,表示每个类别的概率。 进行多类别分类时,准备包含特征和标签的训练数据集,并对特征进行预处理,初始化模型参数,定义模型结构,定义损失函数,并通过优化算法最小化损失函数。 最后,使用测试数据集评估模型性能,进行预测时计算概率分布,选择概率最高的类别作为预测结果。

⓷深度学习有什么限性吗?

最近几年从家到地方都高度重新一代工智能的发展,推进工智能产业与实体经济深度融合。 很多互联网企业从Google、Facebook、亚马逊到内的华为、BAT等顶尖科技企业,都在大力地高薪招募工智能方面的工程师和专家。深度学习作为工智能的核心技术,受到越来越多的关注。 但是另一方面深度学习技术仍不完美,有待于进一步提升。 很多刚接触深度学习的同学可能比较好奇,目前深度学习技术存在哪些限性呢?主要有以下几方面

一是深度神经网络的模型复杂度高,巨量的参数导致模型尺寸大,难以部署到移动终端设备。

二是模型训练所需的数据量大,而训练数据样本获取、标注成本高,有些场景样本难以获取。

三是应用门槛高,算法建模及调参过程复杂繁琐、算法设计周期、系统实施维护困难。

四是存在可解释性问题,由于内部的参数共享和复杂的特征抽取与组合,很难解释模型到底学习到了什么,但出于安全性考虑以及伦理和法律的需要,算法的可解释性又是十分必要的。

上一篇:自动化测试技术有哪些