全连接神经网络处理数据

- 神经网络

- 2023-10-20 12:57:58

- 1111

⓵多层感知器MLP,全连接网络,DNN三者的关系?三者是不是同一个概念?

欢迎提问,深度分析三层关系:在神经网络域,三层分别是多层感知机(MLP)、全连接网络(FCNetwork)和深度网络神经网络(DNN)术语看似相似,但实际上在概念和应用上有所不同。 我们来一一分解它们之间的联系和区别。

首先,全连接网络(FCNetwork),顾名思义,就是网络每一层的神经元都与网络中的所有神经元相连。 下一层,形成紧密连接。 这种网络结构可以为单个神经网络层的特例。 每层都是一层全连接的节点。

接下来我们看看多层感知器(MLP)。 它是由多个FCLayer堆叠而成。 通过逐层计算,信息在不同层之间传递,构成深度学习模型的基础。 MLP通常用于处理结构化数据,可以通过非线性变换解决复杂的函数拟合问题。

但是,深度神经网络(DNN)的概念更广泛。 DNN不仅包括MLP,还结合了卷积神经网络(CNN)的元素。 CNN特别适合处理图像和等数据,主要通过部连接和共享权重来提取特征。 在DNN中,FCLayer通常用作网络的最后一层,对全特征进行整合和分类。 因此,DNN可以看作是结合了MLP和CNN的优点,形成多模态、复杂、多层的网络结构。

综上所述,虽然MLP、FCNetwork和DNN都涉及多层神经网络,但它们的侧重点和范围有所不同。 MLP和FCNetwork更倾向于结构化数据处理,而DNN在此基础上增加了CNN的特征提取能力,使其在图像识别、语言处理等域表现出色。 了解它们的差异和互补性可以帮助我们更好地将这些强大的工具应用到实际问题中。

⓶全连接神经网络

深入理解全连接神经网络1.工智能、机器学习和深度学习之间的关系

工智能是一个专注于复杂自动化的域。 智力作品机器科学是一门工智能,专注于计算机通过观察数据进行学习,而深度学习,特别是神经网络模型,是一种从数据中学习表示的先进技术。

2.然而,复杂的问题,例如图像识别和语音识别,需要机器学习并从大量数据中学习规则。 深度学习与神经网络一样,通过多层结构自动学习输入数据的有效表示。

3神经网络模型开发

感知器是基础,接收输入信号并通过活函数对其进行处理。 多层感知器是感知器的堆栈,由输入层、隐层和输出层组成。 活函数,如Sigmoid和ReLU,在信号转换和传输中起着关键作用。

4.他们之间在训练中,使用损失函数(例如误差方差或交叉熵)来估计预测与实际结果之间的差异。 通过优化器(例如随机下降斜率、力矩模式等)调整权重和偏差,以最大程度地减少损失。

示例:通过反向传播算法训练5层神经网络,并用于sin函数,演示神经网络模型在实际问题中的应用。

⓷深度学习——1.全连接神经网络(NN)

深度学习的基石,全连接神经网络(NN),就像大脑的神经元网络一样,是实现深度学习的关键。 对神经网络的更深入的了解无疑将揭开深度学习的奥秘。

全连接神经网络由三个核心组件构建:输入层、隐层和输出层。 每层由许多神经元织而成输入层接收训练数据的特征向量数据通过连接点之间微调的权重逐层传递,直到到达最后一层信息。

需要注意的是,隐层的数量可以是无限的,但是输入层和输出层始终保清晰的边界,一次只输入一个样本,并且只输出一个预测结果一次输出。 理论上,通过增加隐层、丰富训练数据,可以增加神经网络的复杂度,几乎可以组装任何复杂的数据模式。

神经网络有着广泛的应用,它们不仅擅分类任务,还可以处理回归问题,将数据从输入映射到目标输出。

在专门的作中,数据经过输入层并首先进入第一层,其中权重与输入相乘以形成新的特征。 然后,通过sigmoid、ReLU等非线性函数活该特征,赋予模型更强的表达能力。 例如,假设第一层的活函数为ReLU,那么经过计算,第二层的输入为在下一层中重复这个过程,直到数据在输出层中形成最终的预测结果。

但是,模型优化并非一朝一夕就能完成。 通过反向传播算法,我们计算梯度,并根据预测与实际结果的差异调整每个权重W的值,以最小化误差。 当模型的性能达到预期时,我们停止迭代,让神经网络通过调整来学习和改进。

⓸什么是全连接神经网络?怎么理解“全连接”?

1.全连接神经网络分析:对于第n-1层和第n层,第n-1层中的任何节点都连接到第n层中的所有节点。 即计算第n层每个节点时,活函数的输入是第n-1层所有节点的权重。

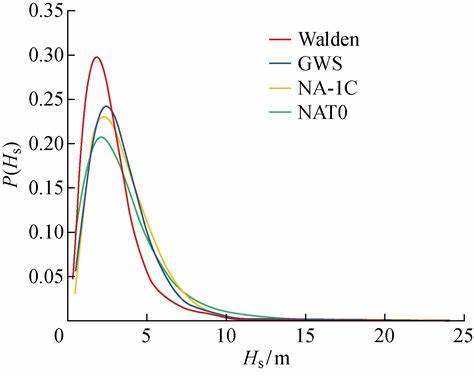

2.全连接神经网络示意图:

3.“全连接”是一个很好的模型,但网络确实如此。 当你年纪大了,你的训练速度就会很慢。 部分连接认为是切断两个节点之间的直接连接,从而显着减少训练时的计算量。

上一篇:一键生成数据分析报告

下一篇:张雪峰评价电气自动化