卷积神经网络优化方法

- 神经网络

- 2024-08-01 12:00:13

- 931

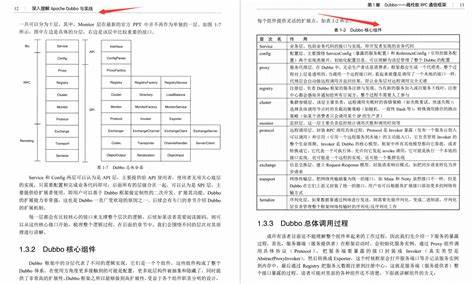

随着技术的发展,研究人员提出了多种优化算法,包括Im2col、Winograd 等等。本文首先定义卷积神经网络的概念,继而简要介绍几种常见的优化方法,并讨论作者在该领域的一些经验。卷积神经网络的概念卷积神经网络(Convolution简单理解就是,卷积神经网络的权重矩阵往往稠密且巨大,从而计算开销大,有一种办法是采用低秩近似的技术将该稠密矩阵由若干个小规模矩阵近似重构出来

本文将探索深度卷积神经网络中的参数优化策略,介绍常用的优化算法和技巧,并讨论其优缺点,以及未来的发展方向。常用的参数优化算法:在深度卷积神-人工智能、CV、注意力机制、神经网络、卷积,吹爆!这可能是导师都不讲的神经网络算法教程,清华教授手把手带你入门CNN、RNN、DQN、GAN、GNN、

卷积神经网络在减少计算量,加快训练和/或inference的速度,减少存储空间等方面的优化主要有以下几种方案: 改进网络结构ResNet网络中的bottleneck结构就是这种方法的典型例子。bottleneck首先通过1x1的卷积层压缩通道数,然后使用3x3的卷积层计算,最后又用1x1的卷积层恢复到原来的通道数(ResNet中通道数压缩比为4)。这种方法大量减少了参数数量,提高了准确率。压缩针对当前神经网络的优化算法进行了总结,并利用简单的CNN网络在NMIST数据集上进行实验,探讨不同的优化方法的效果好坏。其中考虑了四种神经网络训