spark一般如何数据分析的

- 数据分析

- 2024-07-30 18:40:35

- 4208

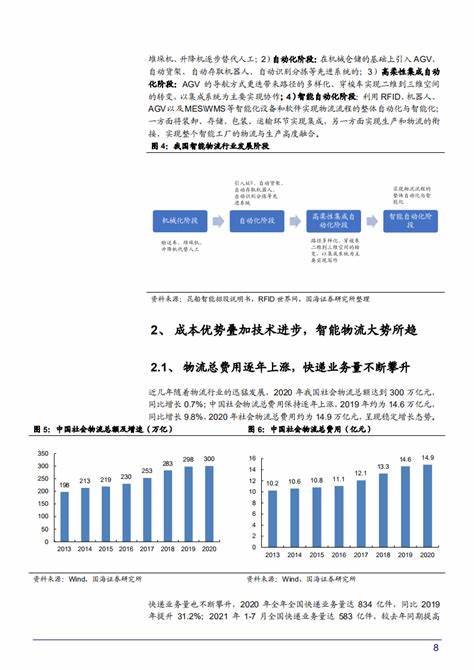

spark数据分析共计60条视频,包括:spark_安装前准备、spark_local模式、spark_pyspark_local模式等,UP主更多精彩视频,请关注UP账号。活跃用户地域信息分析用例5:用户浏览深度分析本项目用到的文件获取如下,提取码:6xdx 注意:本文都是在spark-shell环境下完成用例1:数据清洗读入日

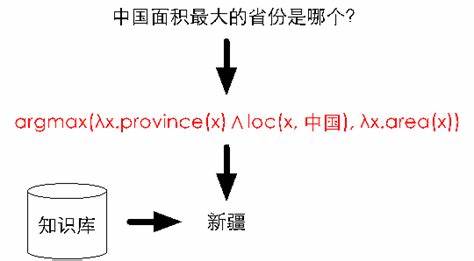

要基于Spark实现数据分析,通常可以按照以下步骤进行: 数据准备:首先要将需要分析的数据加载到Spark中,可以从文件系统、数据库或其他数据源中读取数据,并将其转换为Spark数据结构(如DataFrame或Dataset)。数据清洗:对数据进行清洗和预处理,包括去除重复值、处理缺失值、数据转换、数据筛选等操作,以保证数据质量。数据探索:通过Spark SQL或DataFrame API等工使用Spark进行数据分析通常需要以下步骤: 准备数据:首先需要准备数据,可以将数据存储在HDFS、S3或其他分布式存储系统中。建立Spark应用程序:使用Spark提供的API,比如Spark SQL、DataFrame、Spark ML等,编写数据分析的代码。加载数据:通过Spark读取数据,可以使用DataFrame API加载结构化数据,也可以使用RDD API加载非结构化数据。数据

Spark做数据分析在大数据时代,数据分析变得越来越重要。而Apache S51CTO博客已为您找到关于利用spark进行数据分析的相关内容,包含IT学习相关文档代码介绍、相关教程视频课程,以及利用spark进行数据分析问答内容。更多

上一篇:广东自动化设备生产厂家

下一篇:数据分析怎么看才是正常的