神经网络基本结构示意图

- 神经网络

- 2024-06-11 12:21:25

- 1502

循环神经网络(RNN)在处理序列数据的战场上,循环神经网络(RNN)就像记忆大师。

隐藏层存储单元允许信息在时间范围内流动。

如图2所示,RNN是通过完整的神经网络精心编织而成的。

计算过程是输入、隐藏层状态和权重矩阵之间的复杂舞蹈。

单向RNN只向前看,就像只有一片叶子的独木舟,而双向RNN(图3)则采用双向方法,同时考虑向前和向后。

每个权重矩阵都是一个独立且精确的导航装置。

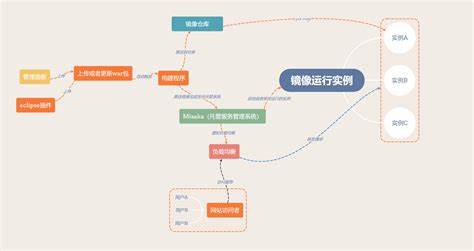

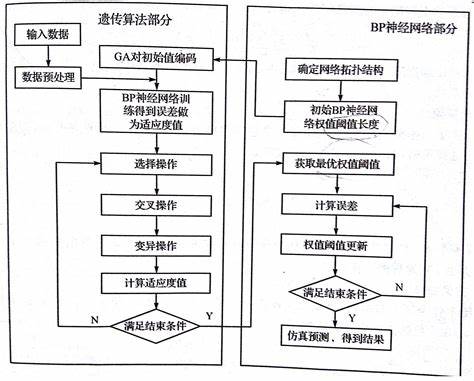

双向循环神经网络就像有洞察力的眼睛,弥补了单向循环神经网络的局限性。 对于需要详细检查周围环境的任务来说,它的功能更加强大。 。 在训练过程中,BPTT算法就像一个精密调音器,通过前向和后向两种方式调整权重矩阵的旋律。 图1和图2展示了RNN的基本结构和动态扩展,图3展示了双向RNN的深层结构。

深度RNN通过重叠多个隐藏层来增加学习的深度和广度,但这也需要大量数据的馈送。 时间步长,类似于RNN的呼吸节律,决定了如何找到序列数据中的相关性。 与任何强大的语言一样,参数共享通过允许模型理解和捕获序列中的模式来简化复杂性。 图2显示了这种魔力如何随着时间的推移发挥作用。

BPTT算法是RNN训练的中流砥柱,通过计算梯度和随机梯度下降来指导模型稳步前进。 这与传统的反向传播类似,但需要跨时间步长的积累,就像探索时间的奥秘一样。 深入理解BPTT公式和Softmax函数的推导是理解RNN训练的关键。 然而,长序列的挑战也随之出现,梯度消失和爆炸问题困扰着模型的长程依赖学习。

面对这些问题,解决办法就像黎明一样。 梯度裁剪可以让你对抗爆炸性的梯度,但看不见的梯度消失需要更多的技巧和耐心。 让我们用一个例子来阐明RNN在处理长句子时如何摆脱梯度消失的迷雾。

RNN有多种架构,从基本的VanillaNeuralNetworks,到具有输入输出序列的1toN模型,到具有单一输出而不是序列的Nto1结构,它们在文本等领域的才能将得到展示。 分类和情感分析。 Nto1和NtoN结构特别擅长处理相等长度的序列,例如CharRNN生成的诗歌段落。 编码器-解码器(Seq2Seq)模型就像机器翻译中的灵魂伴侣,处理不等长的序列。 Attention机制也是一个额外的好处,它提高了Seq2Seq的整体性能并覆盖了广阔的翻译领域。 理解和对话。

探索知识边界并创建深度学习、RNN、Seq2Seq、Attention等导航图。 如果你想了解更多关于机器学习的精彩故事,别忘了关注我的个人微信公众号Microstrong。 在那里,分享了更多有关序列数据处理的秘密和内容。 [1-9][10]

双向循环神经网络就像有洞察力的眼睛,弥补了单向循环神经网络的局限性。 对于需要详细检查周围环境的任务来说,它的功能更加强大。 。 在训练过程中,BPTT算法就像一个精密调音器,通过前向和后向两种方式调整权重矩阵的旋律。 图1和图2展示了RNN的基本结构和动态扩展,图3展示了双向RNN的深层结构。

深度RNN通过重叠多个隐藏层来增加学习的深度和广度,但这也需要大量数据的馈送。 时间步长,类似于RNN的呼吸节律,决定了如何找到序列数据中的相关性。 与任何强大的语言一样,参数共享通过允许模型理解和捕获序列中的模式来简化复杂性。 图2显示了这种魔力如何随着时间的推移发挥作用。

BPTT算法是RNN训练的中流砥柱,通过计算梯度和随机梯度下降来指导模型稳步前进。 这与传统的反向传播类似,但需要跨时间步长的积累,就像探索时间的奥秘一样。 深入理解BPTT公式和Softmax函数的推导是理解RNN训练的关键。 然而,长序列的挑战也随之出现,梯度消失和爆炸问题困扰着模型的长程依赖学习。

面对这些问题,解决办法就像黎明一样。 梯度裁剪可以让你对抗爆炸性的梯度,但看不见的梯度消失需要更多的技巧和耐心。 让我们用一个例子来阐明RNN在处理长句子时如何摆脱梯度消失的迷雾。

RNN有多种架构,从基本的VanillaNeuralNetworks,到具有输入输出序列的1toN模型,到具有单一输出而不是序列的Nto1结构,它们在文本等领域的才能将得到展示。 分类和情感分析。 Nto1和NtoN结构特别擅长处理相等长度的序列,例如CharRNN生成的诗歌段落。 编码器-解码器(Seq2Seq)模型就像机器翻译中的灵魂伴侣,处理不等长的序列。 Attention机制也是一个额外的好处,它提高了Seq2Seq的整体性能并覆盖了广阔的翻译领域。 理解和对话。

探索知识边界并创建深度学习、RNN、Seq2Seq、Attention等导航图。 如果你想了解更多关于机器学习的精彩故事,别忘了关注我的个人微信公众号Microstrong。 在那里,分享了更多有关序列数据处理的秘密和内容。 [1-9][10]